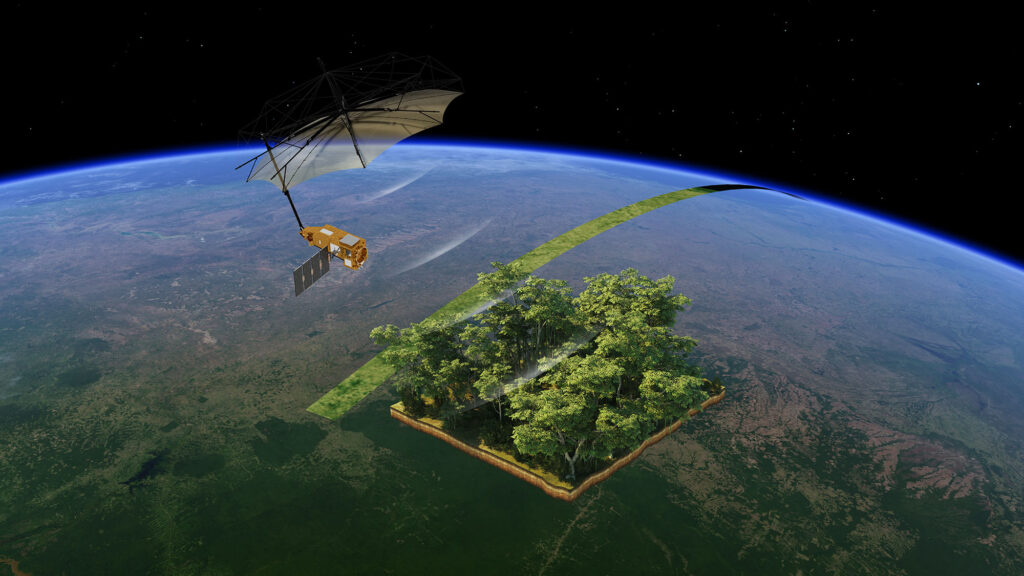

V pátek 10. dubna se kolem Země prosmýkly hned dvě sondy (evropská MPO a japonská MMO alias Mio) a ještě k tomu přeletový modul MTM. Řeč je samozřejmě o jedné jediné sestavě, která míří na misi BepiColombo. Kamery MCAM během tohoto průletu nelenily a pořizovaly snímky naší planety. Dva animované gify, které Vám dnes přinášíme, vznikly 9. dubna (tedy den před průletem) a v den průletu. Můžete se tedy těšit jak na postupné zvětšování Země, tak i na průlet v těsné blízkosti naší planety.

První gif vznikl 9. dubna mezi 13:25 a 23:04 SELČ, přičemž fotky vznikaly s desetiminutovými rozestupy. Během této fáze sestava dosáhla rychlosti vůči naší planetě více než 100 000 km/h a vzdálenost BepiColombo od Země se zmenšila z 281 940 km (při pořízení prvního snímku) na 128 000 km (při pořízení snímku posledního.

Zdroj: https://www.esa.int/

Druhá sekvence snímků byla pořízena 10. dubna mezi 5:03 SELČ a 6:15 SELČ, přičemž tentokrát byly rozestupy mezi jednotlivými snímky jen několikaminutové. Série vznikla těsně před nejbližším přiblížením a vzdálenost mezi sestavou a Zemí během pořizování fotek poklesla z 26 700 km na pouhých 12 800 km.

Zdroj: https://www.esa.int/

Pro BepiColombo šlo o první z celkem devíti gravitačních manévrů, které mají upravit její dráhu pro usazení na oběžné dráze kolem Merkuru. Sestavu tedy čeká ještě osm dalších gravitačních manévrů, ale už žádný nebude u Země. BepiColombo od nás už nikdy nebude tak blízko. Během sedmileté přeletové fáze k nejmenší a nejvnitřnější planetě Sluneční soustavy ještě BepiColombo dvakrát využije gravitace Venuše (říjen 2020 a srpen 2021) a šestkrát gravitace Merkuru (říjen 2021, červen 2022, červen 2023, září 2024, prosinec 2024 a leden 2025), aby brzděním vzdorovala gravitačnímu přitahování od Slunce. K takovému zbrždění se dá použít buďto mnoho pohonných látek nebo komplikovaná trajektorie s mnoha průlety – jinak by se BepiColombo nemohla v prosinci 2025 usadit na správné dráze kolem Merkuru.

Zdroje informací:

http://www.esa.int/

http://www.esa.int/

https://en.wikipedia.org/

Zdroje obrázků:

http://www.esa.int/…/17404593-1-eng-GB/BepiColombo_Earth_flyby.jpg

https://www.esa.int/…/BepiColombo_closing_in_on_Earth_ahead_of_flyby_full_sequence.gif

https://www.esa.int/…/BepiColombo_s_last_close-ups_of_Earth_during_flyby.gif

Jedním slovem Úžasné 🙂

Super článek. Proč jsou ty kamery černobílé? Má to nějaký praktický důvod, je to levnější, nebo něco jiného?

Dělá se to tak běžně, je to technicky jednodušší.

Technicky je to přeci úplně jedno. Rozdíl je pouze na čipech, kde u barevné kamery je Bayerova maska. Ale technika ani věda nepotřebuje nekalibrované obrázky. Ty se dělají předřaznými filtry při snímání monochromatickými kamerami. A ty jsou potom naopak výrazně složitější než barevná kamera. A kamera, která sleduje jen funkčnost nějakých prvků sondy, barvu nepotřebuje.

Tak soucasti technickeho reseni jsou v pripade barevne kamery i ty predradne filtry, jestlize nema nekalibrovana vyznam. Plus hadam se u barevne kamery musi pocitat s vetsim objemem odesilanych dat, coz si take muze vyzadat nejaka technicka reseni.

Ale tak to přeci není. Na vlastním čipu je Bayerova maska napařená z výroby čipu.Nad každým pixelem je jedna barva z Bayerovy matice. Nic se nepředřazuje, žádná mechanika navíc tam není. Je to jen vrstva na čipu. Objem dat je naprosto stejný pro stejný pro stejně velký čip. Je jedno, jestli je 10 Mpixelová kamera monochromatická nebo barevná- stejný počet pixelů = stejný datový tok. Přenáší se pouze úroveň na jednotlivých pixelech

Pokud chcete ke každému pixelu barevnou informaci, tak to prostě je 3x tolik dat (kanál se stupni šedi pro každou barvu). Pixel je u barevných kamer složený se subpixelů různých barev, takže ta Vaše hypotetická 10Mpx kamera musí mít detekčních prvků tolik, kolik by měla 30 (40) Mpx černobílá. Což zase znamená menší sběrnou plochu, větší šum a tak dále. Nebo můžete nechat stejné množství detekčních prvků (ať už jim říkáme pixely nebo subpixely) a rozdělit je podle barev. Pak bude mít výsledný obrázek stejnou velikost, ale každý kanál bude mít přinejlepším třetinu rozlišení. Použití výměnných předřadných filtrů nemá negativní vliv na velikost detektorů ani rozlišení a dá Vám stejné nebo lepší informace (můžete mít víc filtrů s různými vlastnostmi). A navíc, pokud zrovna barevnou informaci nepotřebujete, černobílá kamera je z principu citlivější, sbírá fotony z širší oblasti spektra, takže Vám stačí kratší expoziční časy a můžete snáz snímat tmavší objekty.

Jenže takhle se ty pixely nepočítají. Bayerova maska nejsou žádná subpixely, jsou to úplně normální pixely. Každý se počítá. Takže pokud jsou pixely 4um, tak jsou tak velké jak pro mono , tak i pro barevný čip téže řady ( stačí si najít technické specifikace čipů !) . Takže na stejně velkém čipu jich je stejně. A tak se to počítá. Přenáší se pouze hodnota nasycení každého pixelu – žádná barevná informace z kamery nejde. Naprosto stejně u monochromatické i barevné kamery. Barva vzniká až při zpracování v pozemském softwaru . Bayerova struktura je definovaná čipem a software „ví“ , že např v 10. řádku pixel v 20. sloupci má zelený filtr – a tak ho při zpracování tak zobrazí. A v úrovni podle úrovně vyčteného signálu.

Proto jsem se snažil mluvit o detekčních prvcích, abysme se nezamotali do pixelů a subpixelů. Zkusím to tedy z datového konce, kde o pixelech není sporu.

RGB obraz má 3x více dat, na tom se snad shodneme, protože o každém pixelu máme 3x tolik informací (jeho intenzitu ve 3 kanálech). A je přitom celkem jedno, jestli to kódujeme pixel po pixelu ve 24 bitech, nebo spíchneme dohromady 3 osmibitové obrázky za sebou (datovou kompresi teď ignoruji). Abysme získali ty informace o intenzitě každé z barev v každém pixelu, musíme mít pro každý pixel detekční prvek pro danou barvu. V případě černobílé kamery stačí tedy jeden detekční prvek, pro barevnou 3 (u Bayerovy masky 4, neb zelený je tam dvakrát). To jsou ty subpixely, o kterých jsem mluvil. Jak se to počítá oficiálně nevím, nicméně fyzicky v reálu to je tak, že tam je 4x více detekčních prvků, které musí být přiměřeně menší.

Teď jsem ještě koukal na wikipedii a narazil jsem na zajímavou citaci, která by vysvětlovala, proč se neshodneme. „Výsledkem snímání přes Bayerovu masku je sice snímek se stejným počtem pixelů jako rozlišení čipu, ale každý pixel obsahuje údaje jen o jedné dopadající barvě. Další dvě barevné složky nutné pro vznik barevného obrázku je potřeba dopočítat.“ Mně vůbec nenapadlo o nějakém dopočítávání vůbec uvažovat. Ve vědě jde o surová data. S těmi je to tak, jak píšu.

Zkusme si nevymýšlet názvosloví. Detekční prvek = pixel. Nic jiného na tom snímači není.Podívej se prosím, na datasheet nějakého snímače a zjistíš, že existují ve 2 provedeních : s barevnou maskou a bez ní. Stejný počet prvků, stejný datový tok, naprosto stejné schema. Čipy 12,14 nebo 16 bitů. Z každého pixelu. Žádná barevná informace z čipu nejde. , nic se zde neslučuje do nějakého superpixelu nebo jak tomu říkáš.

To , co se z toho tvoří při zpracování a jak , je už něco jiného

Dobře, pokud to berete takhle, v pořádku. Nicméně to znamená, že data ze senzoru, týkající se červeného kanálu, mají čtvrtinové rozlišení proti datům ze stejného čipu bez barevné masky. Protože jen čtvrtina pixelů snímá v červené oblasti. Výsledný datový tok je stejný, ale rozdělený do třech kanálů (nebo čtyřech? Nevím, jak se tady řeší to dvojnásobné množství zelených kanálů). Každopádně dochází ke ztrátě rozlišení, ke které předsazením výměnného filtru a opakovanému snímání více filtry nedochází.

Jinak jsem na to koukal a máte pravdu, termín subpixel se používá u zobrazovačů, ne u detektorů. Fakticky vzato mi to ale přijde natolik analogický přístup, že si myslím, že to nedává valného smyslu. Nicméně uznávám, že jsem ten termín neužíval technicky správně (proto jsem taky zaváděl ten detekční prvek). Snad jsem ale dokázal vysvětlit, co mám na mysli.

Ano, rozlišení pro R a B kanál je 1/4, u G kanálu potom 1/2. Analogicky je to i s citlivostí. To jsou také důvody, proč se s barevnou kamerou v průzkumu vesmíru ( ať pozemském, nebo kosmickém) prakticky nesetkáte, zrovna tak, jako v pozemských laboratořích nebo technice.

Naopak, v běžném životě se barevné kamery používají, a všechny pracují na stejném principu, s Bayerovou maskou na pixelech čipu a zpracováním obrazu softwarově při tvorbě snímků. A to s tím sníženým rozlišením a citlivostí. Takhle pracují všechna zobrazovací zařízení, s kterými se v běžném životě setkáváme ( foťáky, kamery …)

Ve vesmíru vznikají enormně ostré snímky, s totálně ostrými přechody světlo – tma. Je to dáno tím, že chybí rozptýlené světlo. Takže jeden pixel je světlý, a vedlejší už může být zcela černý. Barevná maska (Bayer pattern) na čipu má tu nectnost, že právě na těchto přechodech generuje chyby – jasně barevné bodíky v místech, kde nemají co dělat. Prostě ten osvětlený pixel je třeba „zelený“ a ten ve tmě je „červený“ – a je to pak někdy bráno jako informace o barvě, nikoli o tom, že je tam kontrastní přechod.

Pokud barvu nepotřebuji (vím, jakou barvu má solární panel, a pokud je v něm díra, nebo se nevyklopil, barva na tom už nic nemění), tak je lépe nechat čip bez filtru. Obrázek je pak v detailech lepší. Pokud barvu potřebuji, má nějaký vědecký význam, třeba studuji porost na Zemi, tak by mi ty chyby mohly vadit – černá puklina v poušti by vypadala, že tam roste několik zelených (modrých, červených) keříků. Proto se používají barevné filtry, motorkem se mění, času je na to obvykle dost. Filtrů je pak často víc, než trojice R-G-B, kamera pak vidí i to, co lidské oko nepostřehne – třeba rozliší víc druhů hornin apod.

Pro David R:Dík, to je perfektní vysvětlení

Jenom doplním, že černobílá kamera bez barevného filtru je kromě viditelného světla sama o sobě citlivá na blízkou infračervenou oblast spektra.

Nádhera! Jen škoda, že na příletové sekvenci není vidět i Měsíc.

Sestava byla už v té době docela blízko a vzhledem k úzkému zornému poli byla ta pravděpodobnost vcelku malá. Ale bylo by to hezké.